麻省理工学院和布朗大学研究人员的一项新研究描述了深度分类器训练过程中出现的几个特性,深度分类器是一种人工神经网络,通常用于图像分类、语音识别和自然语言处理等分类任务。

这篇论文,“用平方损失训练的深度分类器的动力学:归一化、低秩、神经崩溃和泛化边界”,今天发表在《研究》杂志上,是第一个从理论上探索用平方损失训练深度分类器的动力学,以及诸如秩最小化、神经崩溃和神经元激活与层的权重之间的对偶性等属性是如何交织在一起的。

在这项研究中,作者重点研究了两种类型的深度分类器:全连接深度网络和卷积神经网络(cnn)。

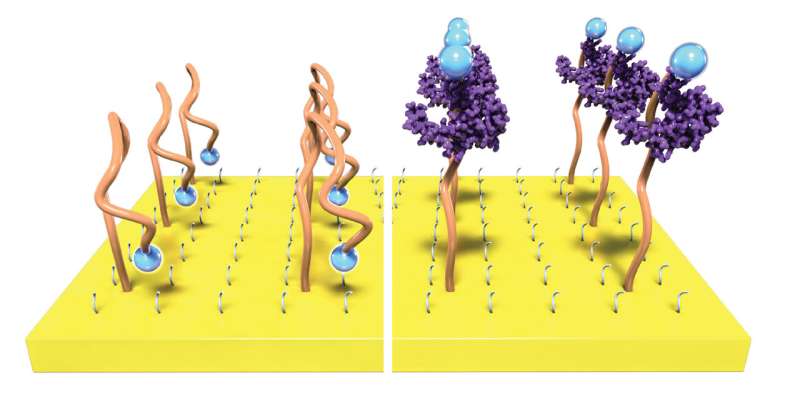

之前的一项研究研究了大型神经网络在训练的最后阶段发展的结构特性。该研究集中在网络的最后一层,并发现为适应训练数据集而训练的深度网络最终会达到一种被称为“神经崩溃”的状态。当神经崩溃发生时,网络将一个特定类的多个示例(例如猫的图像)映射到该类的单个模板。理想情况下,每个类的模板应该尽可能远离彼此,使网络能够准确地分类新示例。

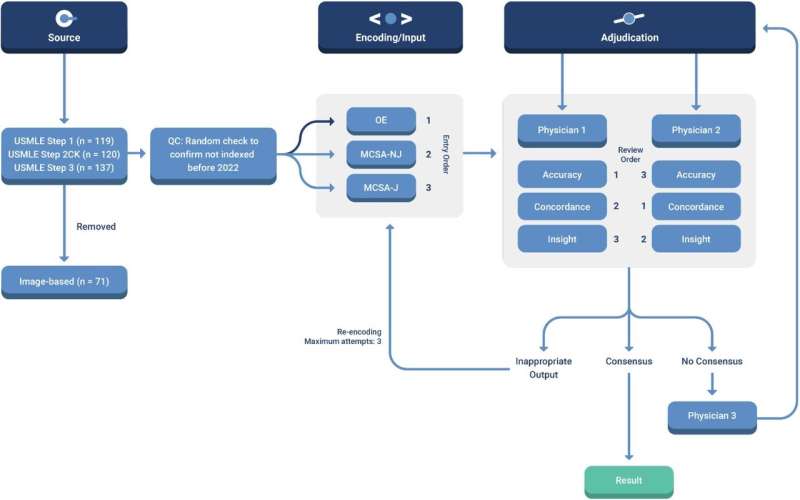

麻省理工学院大脑、思想和机器中心的一个小组研究了网络可以实现神经崩溃的条件。具有随机梯度下降(SGD)、权重衰减正则化(WD)和权重归一化(WN)这三种成分的深度网络,如果经过训练以拟合其训练数据,将显示神经崩溃。与早期研究的经验方法相比,麻省理工学院的研究小组采取了一种理论方法,证明神经崩溃来自于使用SGD、WD和WN的平方损失的最小化。

合著者、麻省理工学院麦戈文研究所博士后Akshay Rangamani表示:“我们的分析表明,神经崩溃来自于高度表达的深度神经网络的平方损失最小化。它还强调了权重衰减正则化和随机梯度下降在推动神经崩溃解决方案方面发挥的关键作用。”

权重衰减是一种正则化技术,通过减少权重的大小来防止网络过度拟合训练数据。权重归一化对网络的权重矩阵进行缩放,使它们具有相似的缩放。低秩是指矩阵具有少量非零奇异值的性质。泛化边界为网络准确预测在训练期间未见过的新示例的能力提供了保证。

作者发现,预测低秩偏差的同一理论观测也预测了权重矩阵和网络输出中存在固有SGD噪声。这种噪声不是由SGD算法的随机性产生的,而是由秩最小化和数据拟合之间有趣的动态权衡产生的,这提供了一个内在的噪音源,类似于在混沌状态下动态系统中发生的情况。这种类随机搜索可能有利于泛化,因为它可以防止过度拟合。

有趣的是,这一结果验证了经典的泛化理论,表明传统的边界是有意义的。它也为稀疏网络(如cnn)相对于密集网络的许多任务的优越性能提供了理论解释,”麻省理工学院麦戈文研究所博士后Tomer Galanti评论道。事实上,作者证明了具有局部化内核的cnn的新的基于范数的泛化边界,即在其权重矩阵中具有稀疏连通性的网络。

在这种情况下,泛化可以比密集连接的网络好几个数量级。这一结果验证了经典的泛化理论,表明它的边界是有意义的,并与最近一些对过去的泛化方法表示怀疑的论文相反。它还为稀疏网络(如cnn)相对于密集网络的优越性能提供了理论解释。到目前为止,cnn而不是密集网络代表了深度网络的成功故事,这一事实几乎完全被机器学习理论所忽视。相反,这里提出的理论表明,这是一个重要的洞察,为什么深度网络工作得这么好。

“这项研究提供了首批理论分析之一,涵盖了深度网络中的优化、泛化和近似,并为训练过程中出现的特性提供了新的见解,”合著者Tomaso Poggio说,他是麻省理工学院大脑与认知科学系的尤金·麦克德莫特教授,也是大脑、思想和机器中心的联合主任。“我们的研究结果有可能促进我们对深度学习为什么如此有效的理解。”

更多信息:Mengjia Xu等人,用平方损失训练的深度分类器的动力学:归一化,低秩,神经崩溃和泛化边界,研究(2023)。DOI: 10.34133 / research.0024由麻省理工学院提供

本文由麻省理工学院新闻(web.mit.edu/newsoffice/)转载,这是一个流行的网站,涵盖了关于麻省理工学院研究、创新和教学的新闻。

引用:对深度分类器训练动态的新见解(2023,3月8日)检索于2023年3月8日从https://techxplore.com/news/2023-03-insights-dynamics-deep.html此文档 作品受版权保护。除为私人学习或研究目的而进行的公平交易外,未经书面许可,不得转载任何部分。的有限公司 Ntent仅供参考之用。 点击分享到